Проблемы поиска информации: история и технологии. Эффективные советы по поиску информации в интернете

c Вячеслав Тихонов , Ноябрь 2000 atomzone.hypermart.net

1. Введение

2. Поисковые системы

2.1. Как работают механизмы поиска 2.2. Сравнительный обзор поисковых систем

3. Поисковые роботы

3.1. Использование поисковых роботов

3.1.1. Статистический анализ 3.1.2. Обслуживание гипертекстов 3.1.3. Зазеркаливание 3.1.4. Исследование ресурсов 3.1.5. Комбинированное использование

3.2. Повышение затрат и потенциальные опасности при использовании поисковых роботов

3.2.1.Сетевой ресурс и загрузка сервера 3.2.2.Обновление документов

3.3. Роботы / агенты клиента

3.3.1.Плохие программные реализации роботов

4.1. Определение роботом, какую информацию включать / исключать 4.2. Формат файла /robots.txt. 4.3. Записи (records) файла /robots.txt 4.4. Расширенные комментарии формата. 4.5. Определение порядка перемещения по Сети 4.6. Подведение итоговых данных

5. Заключение

1. Введение

Основные протоколы, используемые в Интернет (в дальнейшем также Сеть), не обеспечены достаточными встроенными функциями поиска, не говоря уже о миллионах серверах, находящихся в ней. Протокол HTTP, используемый в Интернет, хорош лишь в отношении навигации, которая рассматривается только как средство просмотра страниц, но не их поиска. То же самое относится и к протоколу FTP, который даже более примитивен, чем HTTP. Из-за быстрого роста информации, доступной в Сети, навигационные методы просмотра быстро достигают предела их функциональных возможностей, не говоря уже о пределе их эффективности. Не указывая конкретных цифр, можно сказать, что нужную информацию уже не представляется возможным получить сразу, так как в Сети сейчас находятся миллиарды документов и все они в распоряжении пользователей Интернет, к тому же сегодня их количество возрастает согласно экспоненциальной зависимости. Количество изменений, которым эта информация подвергнута, огромно и, самое главное, они произошли за очень короткий период времени. Основная проблема заключается в том, что единой полной функциональной системы обновления и занесения подобного объема информации, одновременно доступного всем пользователям Интернет во всем мире, никогда не было. Для того, чтобы структурировать информацию, накопленную в сети Интернет, и обеспечить ее пользователей удобными средствами поиска необходимых им данных, были созданы поисковые системы.

2. Поисковые системы

Поисковые cистемы обычно состоят из трех компонент:

агент (паук или кроулер), который перемещается по Сети и собирает информацию;

база данных, которая содержит всю информацию, собираемую пауками;

поисковый механизм, который люди используют как интерфейс для взаимодействия с базой данных.

2.1 Как работают механизмы поиска

Cредства поиска и структурирования, иногда называемые поисковыми механизмами, используются для того, чтобы помочь людям найти информацию, в которой они нуждаются. Cредства поиска типа агентов, пауков, кроулеров и роботов используются для сбора информации о документах, находящихся в Сети Интернет. Это специальные программы, которые занимаются поиском страниц в Сети, извлекают гипертекстовые ссылки на этих страницах и автоматически индексируют информацию, которую они находят для построения базы данных. Каждый поисковый механизм имеет собственный набор правил, определяющих, как cобирать документы. Некоторые следуют за каждой ссылкой на каждой найденной странице и затем, в свою очередь, исследуют каждую ссылку на каждой из новых страниц, и так далее. Некоторые игнорируют ссылки, которые ведут к графическим и звуковым файлам, файлам мультипликации; другие игнорируют cсылки к ресурсам типа баз данных WAIS; другие проинструктирова-ны, что нужно просматривать прежде всего наиболее популярные страницы.

Агенты - самые "интеллектуальные" из поисковых средств. Они могут делать больше, чем просто искать: они могут выполнять даже транзакции от Вашего имени. Уже сейчас они могут искать cайты специфической тематики и возвращать списки cайтов, отсортированных по их посещаемости. Агенты могут обрабатывать содержание документов, находить и индексировать другие виды ресурсов, не только страницы. Они могут также быть запрограммированы для извлечения информации из уже существующих баз данных. Независимо от информации, которую агенты индексируют, они передают ее обратно базе данных поискового механизма.

Общий поиск информации в Сети осуществляют программы, известные как пауки. Пауки сообщают о содержании найденного документа, индексируют его и извлекают итоговую информацию. Также они просматривают заголовки, некоторые ссылки и посылают проиндексированную информацию базе данных поискового механизма.

Кроулеры просматривают заголовки и возращают только первую ссылку.

Роботы могут быть запрограммированы так, чтобы переходить по различным cсылкам различной глубины вложенности, выполнять индексацию и даже проверять ссылки в документе. Из-за их природы они могут застревать в циклах, поэтому, проходя по ссылкам, им нужны значительные ресурсы Сети. Однако, имеются методы, предназначенные для того, чтобы запретить роботам поиск по сайтам, владельцы которых не желают, чтобы они были проиндексированы.

Агенты извлекают и индексируют различные виды информации. Некоторые, например, индексируют каждое отдельное слово во встречающемся документе, в то время как другие индексируют только наиболее важных 100 слов в каждом, индексируют размер документа и число слов в нем, название, заголовки и подзаголовки и так далее. Вид построенного индекса определяет, какой поиск может быть сделан поисковым механизмом и как полученная информация будет интерпретирована.

Агенты могут также перемещаться по Интернет и находить информацию, после чего помещать ее в базу данных поискового механизма. Администраторы поисковых систем могут определить, какие сайты или типы сайтов агенты должны посетить и проиндексировать. Проиндексированная информация отсылается базе данных поискового механизма так же, как было описано выше.

Люди могут помещать информацию прямо в индекс, заполняя особую форму для того раздела, в который они хотели бы поместить свою информацию. Эти данные передаются базе данных.

Когда кто-либо хочет найти информацию, доступную в Интернет, он посещает страницу поисковой системы и заполняет форму, детализирующую информацию, которая ему необходима. Здесь могут использоваться ключевые слова, даты и другие критерии. Критерии в форме поиска должны соответствовать критериям, используемым агентами при индексации информации, которую они нашли при перемещении по Сети.

База данных отыскивает предмет запроса, основанный на информации, указанной в заполненной форме, и выводит соответствующие документы, подготовленные базой данных. Чтобы определить порядок, в котором список документов будет показан, база данных применяет алгоритм ранжирования. В идеальном случае, документы, наиболее релевантные пользовательскому запросу будут помещены первыми в списке. Различные поисковые системы используют различные алгоритмы ранжирования, однако основные принципы определения релевантности следующие:

Количество слов запроса в текстовом содержимом документа (т.е. в html-коде).

Тэги, в которых эти слова располагаются.

Местоположение искомых слов в документе.

Удельный вес слов, относительно которых определяется релевантность, в общем количестве слов документа.

Эти принципы применяются всеми поисковыми системами. А представленные ниже используются некоторыми, но достаточно известными (вроде AltaVista, HotBot).

Время - как долго страница находится в базе поискового сервера. Поначалу кажется, что это довольно бессмысленный принцип. Но, если задуматься, как много существует в Интернете сайтов, которые живут максимум месяц! Если же сайт существует довольно долго, это означает, что владелец весьма опытен в данной теме и пользователю больше подойдет сайт, который пару лет вещает миру о правилах поведения за столом, чем тот, который появился неделю назад с этой же темой.

Индекс цитируемости - как много ссылок на данную страницу ведет с других страниц, зарегистрированных в базе поисковика.

База данных выводит ранжированный подобным образом список документов с HTML и возвращает его человеку, сделавшему запрос. Различные поисковые механизмы также выбирают различные способы показа полученного списка - некоторые показывают только ссылки; другие выводят cсылки c первыми несколькими предложениями, содержащимися в документе или заголовок документа вместе с ccылкой.

2.2 Сравнительный обзор поисковых систем

Lycos . В Lycos используется следующий механизм индексации:

слова в title заголовке имеют высший приоритет;

слова в начале страницы;

Как и большинство систем, Lycos дает возможность применять простой запрос и более изощренный метод поиска. В простом запросе в качестве поискового критерия вводится предложение на естественном языке, после чего Lycos производит нормализацию запроса, удаляя из него так называемые stop-слова, и только после этого приступает к его выполнению. Почти сразу выдается информация о количестве документов на каждое слово, а позже и список ссылок на формально релевантные документы. В списке против каждого документа указывается его мера близости запросу, количество слов из запроса, попавших в документ, и оценочная мера близости, которая может быть больше или меньше формально вычисленной. Пока нельзя вводить логические операторы в строке вместе с терминами, но использовать логику через систему меню Lycos позволяет. Такая возможность применяется для построения расширенной формы запроса, предназначенной для искушенных пользователей, уже научившихся работать с этим механизмом. Таким образом, видно, что Lycos относится к системе с языком запросов типа "Like this", но намечается его расширение и на другие способы организации поисковых предписаний.

AltaVista . Индексирование в этой системе осуществляется при помощи робота. При этом робот имеет следующие приоритеты:

ключевые фразы, находящиеся в начале странички;

ключевые фразы по количеству вхожденийприсутствия словфраз;

Если тэгов на странице нет, использует первые 30 слов, которые индексирует и показывает вместо описания (tag description)

Наиболее интересная возможность AltaVista - это расширенный поиск. Здесь стоит сразу оговориться, что, в отличие от многих других систем AltaVista поддерживает одноместный оператор NOT. Кроме этого, имеется еще и оператор NEAR, который реализует возможность контекстного поиска, когда термины должны располагаться рядом в тексте документа. AltaVista разрешает поиск по ключевым фразам, при этом она имеет довольно большой фразеологический словарь. Кроме всего прочего, при поиске в AltaVista можно задать имя поля, где должно встретиться слово: гипертекстовая ссылка, applet, название образа, заголовок и ряд других полей. К сожалению, подробно процедура ранжирования в документации по системе не описана, но видно, что ранжирование применяется как при простом поиске, так и при расширенном запросе. Реально эту систему можно отнести к системе с расширенным булевым поиском.

Yahoo . Данная система появилась в Сети одной из первых, и сегодня Yahoo сотрудничает со многими производителями средств информационного поиска, а на различных ее серверах используется различное программное обеспечение. Язык Yahoo достаточно прост: все слова следует вводить через пробел, они соединяются связкой AND либо OR. При выдаче не указывается степень соответствия документа запросу, а только подчеркиваются слова из запроса, которые встретились в документе. При этом не производится нормализация лексики и не проводится анализ на "общие" слова. Хорошие результаты поиска получаются только тогда, когда пользователь знает, что в базе данных Yahoo информация есть наверняка. Ранжирование производится по числу терминов запроса в документе. Yahoo относится к классу простых традиционных систем с ограниченными возможностями поиска.

OpenText . Информационная система OpenText представляет собой самый коммерциализированный информационный продукт в Сети. Все описания больше похожи на рекламу, чем на информативное руководство по работе. Система позволяет провести поиск с использованием логических коннекторов, однако размер запроса ограничен тремя терминами или фразами. В данном случае речь идет о расширенном поиске. При выдаче результатов сообщается степень соответствия документа запросу и размер документа. Система позволяет также улучшить результаты поиска в стиле традиционного булевого поиска. OpenText можно было бы отнести к разряду традиционных информационно-поисковых систем, если бы не механизм ранжирования.

Infoseek . В этой системе индекс создает робот, но он индексирует не весь сайт, а только указанную страницу. При этом робот имеет такие приоритеты:

слова в заголовке title имеют наивысший приоритет;

слова в теге keywords, description и частота вхожденийповторений в самом тексте;

при повторении одинаковых слов рядом выбрасывает из индекса

Допускает до 1024 символов для тега keywords, 200 символов для тэга description;

Если тэги не использовались, индексирует первые 200 слов на странице и использует как описание;

Система Infoseek обладает довольно развитым информационно-поисковым языком, позволяющим не просто указывать, какие термины должны встречаться в документах, но и своеобразно взвешивать их. Достигается это при помощи специальных знаков "+" - термин обязан быть в документе, и "-" - термин должен отсутствовать в документе. Кроме этого, Infoseek позволяет проводить то, что называется контекстным поиском. Это значит, что используя специальную форму запроса, можно потребовать последовательной совместной встречаемости слов. Также можно указать, что некоторые слова должны совместно встречаться не только в одном документе, а даже в отдельном параграфе или заголовке. Имеется возможность указания ключевых фраз, представляющих собой единое целое, вплоть до порядка слов. Ранжирование при выдаче осуществляется по числу терминов запроса в документе, по числу фраз запроса за вычетом общих слов. Все эти факторы используются как вложенные процедуры. Подводя краткое резюме, можно сказать, что Infoseek относится к традиционным системам с элементом взвешивания терминов при поиске.

WAIS . WAIS является одной из наиболее изощренных поисковых систем Internet. В ней не реализованы лишь поиск по нечетким множествам и вероятностный поиск. В отличие от многих поисковых машин, система позволяет строить не только вложенные булевые запросы, считать формальную релевантность по различным мерам близости, взвешивать термины запроса и документа, но и осуществлять коррекцию запроса по релевантности. Система также позволяет использовать усечения терминов, разбиение документов на поля и ведение распределенных индексов. Не случайно именно эта система была выбрана в качестве основной поисковой машины для реализации энциклопедии "Британика" на Internet.

3. Поисковые роботы

За последние годы Всемирная паутина стала настолько популярной, что сейчас Интернет является одним из основных средств публикации информации. Когда размер Сети вырос из нескольких серверов и небольшого числа документов до огромных пределов, стало ясно, что ручная навигация по значительной части структуры гипертекстовых ссылок больше не представляется возможной, не говоря уже об эффективном методе исследования ресурсов.

Эта проблема побудила исследователей Интернет на проведение экспериментов с автоматизированной навигацией по Сети, названной "роботами". Веб-робот - это программа, которая перемещается по гипертекстовой структуре Сети, запрашивает документ и рекурсивно возвращает все документы, на которые данный документ ссылается. Эти программы также иногда называют "пауками", " странниками", или " червями" и эти названия, возможно, более привлекательны, однако, могут ввести в заблуждение, поскольку термин "паук" и "странник" cоздает ложное представление, что робот сам перемещается, а термин "червь" мог бы подразумевать, что робот еще и размножается подобно интернетовскому вирусу-червю. В действительности, роботы реализованы как простая программная система, которая запрашивает информацию из удаленных участков Интернет, используя стандартные cетевые протоколы.

3.1 Использование поисковых роботов

Роботы могут использоваться для выполнения множества полезных задач, таких как статистический анализ, обслуживание гипертекстов, исследования ресурсов или зазеркаливания страниц. Рассмотрим эти задачи подробнее.

3.1.1 Статистический Анализ

Первый робот был создан для того, чтобы обнаружить и посчитать количество веб-серверов в Сети. Другие статистические вычисления могут включать среднее число документов, приходящихся на один сервер в Сети, пропорции определенных типов файлов на сервере, средний размер страницы, степень связанности ссылок и т.д.

3.1.2 Обслуживание гипертекстов

Одной из главных трудностей в поддержании гипертекстовой структуры является то, что ссылки на другие страницы могут становиться " мертвыми ссылками" в случае, когда страница переносится на другой сервер или cовсем удаляется. На сегодняшний день не существует общего механизма, который смог бы уведомить обслуживающий персонал сервера, на котором содержится документ с сылками на подобную страницу, о том, что она изменилась или вобще удалена. Некоторые серверы, например, CERN HTTPD, будут регистрировать неудачные запросы, вызванные мертвыми ссылками наряду с рекомендацией относительно страницы, где обнаружена мертвая cсылка, предусматривая что данная проблема будет решаться вручную. Это не очень практично, и в действительности авторы документов обнаруживают, что их документы содержат мертвые ссылки лишь тогда, когда их извещают непосредственно, или, что бывает очень редко, когда пользователь cам уведомляет их по электронной почте.

Робот типа MOMSPIDER, который проверяет ссылки, может помочь автору документа в обнаружении подобных мертвых ссылок, и также может помогать в обслуживании гипертекстовой структуры. Также роботы могут помочь в поддержании содержания и самой структуры, проверяя соответствующий HTML-документ, его соответствие принятым правилам, регулярные модернизации, и т.д., но это обычно не используется. Возможно, данные функциональные возможности должны были бы быть встроены при написании окружающей среды HTML-документа, поскольку эти проверки могут повторяться в тех случаях, когда документ изменяется, и любые проблемы при этом могут быть решены немедленно.

3.1.3 Зазеркаливание

Зазеркаливание - популярный механизм поддержания FTP архивов. Зеркало рекурсивно копирует полное дерево каталогов по FTP, и затем регулярно перезапрашивает те документы, которые изменились. Это позволяет распределить загрузку между несколькими серверами, успешно справиться с отказами сервера и обеспечить более быстрый и более дешевый локальный доступ, так же как и автономный доступ к архивам. В Сети Интернет зазеркаливание может быть осуществлено с помощью робота, однако на время написания этой статьи никаких сложных средств для этого не существовало. Конечно, существует несколько роботов, которые восстанавливают поддерево страниц и сохраняют его на локальном сервере, но они не имеют средств для обновления именно тех страниц, которые изменились. Вторая проблема - это уникальность страниц, которая состоит в том, что ссылки в скопированных страницах должны быть перезаписаны там, где они ссылаются на страницы, которые также были зазеркалены и могут нуждаться в обновлении. Они должны быть измененены на копии, а там, где относительные ссылки указывают на страницы, которые не были зазеркалены, они должны быть расширены до абсолютных ссылок. Потребность в механизмах зазеркаливания по причинам показателей производительности намного уменьшается применением сложных кэширующих серверов, которые предлагают выборочную модернизацию, что может гарантировать, что кэшированный документ не обновился, и в значительной степени самообслуживается. Однако, ожидается, что cредства зазеркаливания в будущем будут развиваться должным образом.

3.1.4 Исследование ресурсов

Возможно, наиболее захватывающее применение роботов - использование их при исследовании ресурсов. Там, где люди не могут справиться с огромным количеством информации, довольно возможность переложить всю работу на компьютер выглядит довольно привлекательно. Существует несколько роботов, которые собирают информацию в большей части Интернет и передают полученные результаты базе данных. Это означает, что пользователь, который ранее полагался исключительно на ручную навигацию в Сети, теперь может объединить поиск с просмотром страниц для нахождения нужной ему информации. Даже если база данных не содержит именно того, что ему нужно, велика вероятность того, что в результате этого поиска будет найдено немало ссылок на страницы, которые, в свою очередь, могут ссылаться на предмет его поиска.

Второе преимущество состоит в том, что эти базы данных могут автоматически обновляться за определенный период времени так, чтобы мертвые ссылки в базе данных были обнаружены и удалены, в отличие от обслуживания документов вручную, когда проверка часто является спонтанной и не полной. Использование роботов для исследования ресурсов будет обсуждаться ниже.

3.1.5 Комбинированное использование

Простой робот может выполнять более чем одну из вышеупомянутых задач. Например робот RBSE Spider выполняет статистический анализ запрошенных документов и обеспечивает ведение базы данных ресурсов. Однако, подобное комбинированное использование встречается, к сожалению, весьма редко.

3.2 Повышение затрат и потенциальные опасности при использовании поисковых роботов

Использование роботов может дорого обойтись, особенно в случае, когда они используются удаленно в Интернете. В этом разделе мы увидим, что роботы могут быть опасны, так как они предъявляют слишком высокие требования к Сети.

Роботы требуют значительной пропускной способности канала сервера. Во-первых роботы работают непрерывно в течение длительных периодов времени, часто даже в течение месяцев. Чтобы ускорить операции, многие роботы делают параллельные запросы страниц с сервера, ведущие в последствии к повышенному использованию пропускной способности канала сервера. Даже удаленные части Сети могут чувствовать сетевую нагрузку на ресурс, если робот делает большое количество запросов за короткий промежуток времени. Это может привести к временной нехватке пропускной способности сервера для других пользователей, особенно на серверах с низкой пропускной способностью, поскольку Интернет не имеет никаких cредств для балансирования нагрузки в зависимости от используемого протокола.

Традиционно Интернет воспринимался как "свободный", поскольку индивидуальные пользователи не должны были платить за его использование. Однако теперь это поставлено под сомнение, так как особенно корпоративные пользователи платят за издержки, связанные с использованием Сети. Компания может чувствовать, что ее услуги (потенциальным) клиентам стоят оплаченных денег, а страницы, автоматически переданные роботам - нет.

Помимо предъявления требований к Сети, робот также предъявляет дополнительные требования к самому серверу. В зависимости от частоты, с которой он запрашивает документы с сервера, это может привести к значительной загрузке всего сервера и снижению скорости доступа других пользователей, обращающихся к серверу. К тому же, если главный компьютер используется также для других целей, это может быть вообще неприемлемо. В качестве эксперимента автор управлял моделированием 20 параллельных запросов от своего сервера, функционирующего как Plexus сервер на Sun 4/330. Несколько минут машину, замедленную использованием паука, вообще невозможно было использовать. Этот эффект можно почувствовать даже последовательно запрашивая страницы.

Все это показывает, что нужно избегать ситуаций с одновременным запросом страниц. К сожалению, даже современные браузеры (например, Netscape) создают эту проблему, параллельно запрашивая изображения, находящиеся в документе. Сетевой протокол HTTP оказался неэффективным для подобных передач и как средство борьбы с подобными эффектами сейчас разрабатываются новые протоколы.

3.2.2 Обновление документов

Как уже было упомянуто, базы данных, создаваемые роботами, могут автоматически обновляться. К сожалению, до сих пор не имеется никаких эффективных механизмов контроля за изменениями, происходящими в Сети. Более того, нет даже простого запроса, который мог бы определить, которая из cсылок была удалена, перемещена или изменена. Протокол HTTP обеспечивает механизм "If-Modified-Since", посредством которого агент пользователя может определить время модификации кэшированного документа одновременно с запросом самого документа. Если документ был изменен, тогда сервер передаст только его содержимое, так как этот документ уже был прокэширован.

Это средство может использоваться роботом только в том случае, если он сохраняет отношения между итоговыми данными, которые извлекаются из документа: это сама ссылка и отметка о времени, когда документ запрашивался. Это ведет к возникновению дополнительных требований к размеру и сложности базы данных и широко не применяется.

3.3 Роботы / агенты клиента

Загрузка Сети является особой проблемой, связанной с применением категории роботов, которые используются конечными пользователями и реализованы как часть веб-клиента общего назначения (например, Fish Search и tkWWW робот). Одной из особенностей, которая является обычной для этих роботов, является способность передавать обнаруженную информацию поисковым системам при перемещении по Сети. Это преподносится как усовершенствование методов исследования ресурсов, так как запросы к нескольким удаленным базам данных осуществляются автоматически. Однако, по мнению автора, это неприемлемо по двум причинам. Во-первых, операция поиска приводит к большей загрузке сервера, чем даже простой запрос документа, поэтому обычному пользователю могут быть причинены значительные неудобства при работе на нескольких серверах с большими издержками, чем обычно. Во-вторых, ошибочно предполагать, что одни и те же ключевые слова при поиске одинаково релевантны, синтаксически правильны, не говоря уже об оптимальности для различных баз данных, и диапазон баз данных полностью скрыт от пользователя. Например, запрос " Форд и гараж " мог бы быть послан базе данных, хранящей литературу 17-ого столетия, базе данных, которая не поддерживает булевские операторы или базе данных, которая определяет, что запросы относительно автомобилей должны начаться со слова "автомобиль: ". И пользователь даже не знает это.

Другой опасный аспект использования клиентского робота заключается в том, что как только он был распространен по Сети, никакие ошибки уже не могут быть исправлены, не могут быть добавлены никакие знания проблемных областей и никакие новые эффективные свойства не могут его улучшить, как не каждый пользователь впоследствии будет модернизировать этого робота самой последней версией.

Наиболее опасный аспект, однако - большое количество возможных пользователей роботов. Некоторые люди, вероятно, будут использовать такое устройство здраво, то есть ограничиваться некоторым максимумом ссылок в известной области Сети и в течение короткого периода времени, но найдутся и люди, которые злоупотребят им из-за невежества или высокомерия. По мнению автора, удаленные роботы не должны передаваться конечным пользователям, и к счастью, до сих пор удавалось убедить по крайней мере некоторых авторов роботов не распространять их открыто.

Даже не учитывая потенциальную опасность клиентских роботов, возникает этический вопрос: где использование роботов может быть полезно всему Интернет-сообществу для объединения всех доступных данных, а где они не могут быть применены, поскольку принесут пользу только одному пользователю.

"Интеллектуальные агенты" и " цифровые помощники", предназначенные для использования конечным пользователем, который ищет информацию в Интернет, являются в настоящее время популярной темой исследований в компьютерной науке, и часто рассматриваются как будущее Сети. В то же время это действительно может иметь место, и уже очевидно, что автоматизация неоценима для исследований ресурсов, хотя требуется проводить еще больше исследований для того, чтобы их сделать их использование эффективным. Простые управляемые пользователем роботы очень далеки от интеллектуальных сетевых агентов: агент должен иметь некоторое представление о том, где найти определенную информацию (то есть какие услуги использовать) вместо того, чтобы искать ее вслепую. Рассмотрим ситуацию, когда человек ищет книжный магазин; он использует "Желтые страницы" для области, в которой он проживает, находит список магазинов, выбирает из них один или несколько, и посещает их. Клиентский робот шел бы во все магазины в области, спрашивая о книгах. В Сети, как и в реальной жизни, это неэффективно в малом масштабе, и совсем должно быть запрещено в больших масштабах.

3.3.1 Плохие программные реализации роботов

Нагрузка на сеть и серверы иногда увеличивается плохой программной реализацией особенно недавно написанных роботов. Даже если протокол и ссылки, посланные роботом, правильны, и робот правильно обрабатывает возвращенный протокол (включая другие особенности вроде переназначения), имеется несколько менее очевидных проблем.

Автор наблюдал, как несколько похожих роботов управляют вызовом его сервера. В то время, как в некоторых случаях негативные последствия были вызваны людьми, использующими свой сайт для испытаний (вместо локального сервера), в остальных случаях стало очевидно, что они были вызваны плохим написанием самого робота. При этом могут произойти повторные запросы страниц в том случае, если нет никаких записей об уже запрошенных ссылках (что является непростительным), или когда робот не распознает, когда несколько ссылок синтаксически эквивалентны, например, где различаются DNS псевдонимы для одного и того же адреса IP, или где ссылки не могут быть обработаны роботом, например " foo/bar/ baz.html " является эквивалентным "foo/baz.html".

Некоторые роботы иногда запрашивают документы типа GIF и PS, которые они не могут обработать и поэтому игнорируют.

Другая опасность состоит в том, что некоторые области Сети являются почти бесконечными. Например, рассмотрим сценарий, который возвращает страницу со ссылкой на один уровень, расположенный ниже. Он начнет, например, с " /cgi-bin/pit / ", и продолжит с " /cgi-bin/pit/a / ", " /cgi-bin/pit/a/a / ", и т.д. Поскольку такие cсылки могут заманить в робота в ловушку, их часто называют "черными дырами".

4. Проблемы при каталогизации информации

Бесспорен тот факт, что базы данных, наполняемые роботами, популярны. Автор непосредственно регулярно использует такие базы данных для нахождения нужных ему ресурсов. Однако, имеется несколько проблем, которые ограничивают применение роботов для исследования ресурсов в Сети. Одна из них заключается в том, что здесь находится слишком много документов, и все они постоянно динамически изменяются.

Одной из мер эффективности подхода к поиску информации является "отзыв" (recall), содержащий информацию о всех релевантных документах, которые были найдены. Брайен Пинкертон утверждает, что отзыв в индексирующих системах Интернет является вполне приемлемым подходом, так как обнаружение достаточно релевантных документов не проблема. Однако, если сравнивать все множенство информации, доступной в Интернет, с информацией в базе данных, созданной роботом, то отзыв не может быть слишком точным, поскольку количество информации огромно и она очень часто изменяется. Так что практически база данных может не содержать специфического ресурса, который доступен в Интернет в данный момент, и таких документов будет множество, поскольку Сеть непрерывно растет.

4.1. Определение роботом, какую информацию включать / исключать

Робот не может автоматически определить, была ли данная страница в Сети включена в его индекс. К тому же веб-сервера в Интернет могут содержать документы, которые являются релевантными только для локального контекста, документы, которые существуют временно, и т.д. На практике роботы сохраняют почти всю информацию о том, где они побывали. Заметьте, что, даже если робот смог определить, должна ли указанная страница быть исключена из его базы данных, он уже понес накладные расходы на запрос самого файла, а робот, который решает игнорировать большой процент документов, очень расточителен. Пытаясь исправить эту ситуацию, Интернет-сообщество приняло " Стандарт исключений для роботов". Этот стандарт описывает использование простого структурированного текстового файла, доступного в известном месте на сервере ("/robots.txt") и используемого для того, чтобы определить, какая из частей их ссылок должна игнорироваться роботами. Это средство может быть также использовано для того, чтобы предупредить роботов о черных дырах. Каждому типу роботов можно передавать определенные команды, если известно, что данный робот специализируется в конкретной области. Этот стандарт является свободным, но его очень просто осуществить и в нем имеется значительное давление на роботов с попыткой их подчинения.

4.2. Формат файла /robots.txt.

Файл /robots.txt предназначен для указания всем поисковым роботам индексировать информационные сервера так, как определено в этом файле, т.е. только те директории и файлы сервера, которые НЕ описаны в /robots.txt. Это файл должен содержать 0 или более записей, которые связаны с тем или иным роботом (что определяется значением поля agent_id), и указывают для каждого робота или для всех сразу что именно им НЕ НАДО индексировать. Тот, кто пишет файл /robots.txt, должен указать подстроку Product Token поля User-Agent, которую каждый робот выдает на HTTP-запрос индексируемого сервера. Например, нынешний робот Lycos на такой запрос выдает в качестве поля User-Agent:

Lycos_Spider_(Rex)/1.0 libwww/3.1

Если робот Lycos не нашел своего описания в /robots.txt - он поступает так, как считает нужным. При создании файла /robots.txt следует учитывать еще один фактор - размер файла. Поскольку описывается каждый файл, который не следует индексировать, да еще для многих типов роботов отдельно, при большом количестве не подлежащих индексированию файлов размер /robots.txt становится слишком большим. В этом случае следует применять один или несколько следующих способов сокращения размера /robots.txt:

указывать директорию, которую не следует индексировать, и, соответственно, не подлежащие индексированию файлы располагать именно в ней

создавать структуру сервера с учетом упрощения описания исключений в /robots.txt

указывать один способ индексирования для всех agent_id

указывать маски для директорий и файлов

4.3. Записи (records) файла /robots.txt

Общее описание формата записи.

[ # comment string NL ]*

User-Agent: [ [ WS ]+ agent_id ]+ [ [ WS ]* # comment string ]? NL

[ # comment string NL ]*

# comment string NL

Disallow: [ [ WS ]+ path_root ]* [ [ WS ]* # comment string ]? NL

Параметры

Описание параметров, применяемых в записях /robots.txt

[...]+ Квадратные скобки со следующим за ними знаком + означают, что в качестве параметров должны быть указаны один или несколько терминов. Например, после "User-Agent:" через пробел могут быть указаны один или несколько agent_id.

[...]* Квадратные скобки со следующим за ними знаком * означают, что в качестве параметров могут быть указаны ноль или несколько терминов. Например, Вы можете писать или не писать комментарии.

[...]? Квадратные скобки со следующим за ними знаком? означают, что в качестве параметров могут быть указаны ноль или один термин. Например, после "User-Agent: agent_id" может быть написан комментарий.

..|.. означает или то, что до черты, или то, что после.

WS один из символов - пробел (011) или табуляция (040)

NL один из символов - конец строки (015) , возврат каретки (012) или оба этих символа (Enter)

User-Agent: ключевое слово (заглавные и прописные буквы роли не играют). Параметрами являются agent_id поисковых роботов.

Disallow: ключевое слово (заглавные и прописные буквы роли не играют). Параметрами являются полные пути к неиндексируемым файлам или директориям.

# начало строки комментариев, comment string - собственно тело комментария.

agent_id любое количество символов, не включающих WS и NL, которые определяют agent_id различных поисковых роботов. Знак * определяет всех роботов сразу.

path_root любое количество символов, не включающих WS и NL, которые определяют файлы и директории, не подлежащие индексации.

4.4. Расширенные комментарии формата.

Каждая запись начинается со строки User-Agent, в которой описывается каким или какому поисковому роботу эта запись предназначается. Следующая строка: Disallow. Здесь описываются не подлежащие индексации пути и файлы. КАЖДАЯ запись ДОЛЖНА иметь как минимум эти две строки (lines). Все остальные строки являются опциями. Запись может содержать любое количество строк комментариев. Каждая строка комментария должна начинаться с символа # . Строки комментариев могут быть помещены в конец строк User-Agent и Disallow. Символ # в конце этих строк иногда добавляется для того, чтобы указать поисковому роботу, что длинная строка agent_id или path_root закончена. Если в строке User-Agent указано несколько agent_id, то условие path_root в строке Disallow будет выполнено для всех одинаково. Ограничений на длину строк User-Agent и Disallow нет. Если поисковый робот не обнаружил в файле /robots.txt своего agent_id, то он игнорирует /robots.txt.

Если не учитывать специфику работы каждого поискового робота, можно указать исключения для всех роботов сразу. Это достигается заданием строки

Если поисковый робот обнаружит в файле /robots.txt несколько записей с удовлетворяющим его значением agent_id, то робот волен выбирать любую из них.

Каждый поисковый робот будет определять абсолютный URL для чтения с сервера с использованием записей /robots.txt. Заглавные и строчные символы в path_root ИМЕЮТ значение.

Пример 1:

User-Agent: Lycos

Disallow: /cgi-bin/ /tmp/

В примере 1 файл /robots.txt содержит две записи. Первая относится ко всем поисковым роботам и запрещает индексировать все файлы. Вторая относится к поисковому роботу Lycos и при индексировании им сервера запрещает директории /cgi-bin/ и /tmp/, а остальные - разрешает. Таким образом сервер будет проиндексирован только системой Lycos.

4.5. Определение порядка перемещения по Сети

Определение того, как перемещаться по Сети является относительной проблемой. Учитывая, что большинство серверов организовано иерархически, при первом перемещении вширь по ссылкам от вершины на ограниченной глубине вложенности ссылок, более вероятно быстрее найти набор документов с более высоким уровнем релевантности и услуг, чем при перемещении в глубину вложенности ссылок, и поэтому этот метод намного предпочтительнее для исследования ресурсов. Также при перемещении по ссылкам первого уровня вложенности более вероятно найти домашние страницы пользователей с ссылками к другим, потенциально новым, серверам, и поэтому при этом существует большая вероятность найти новые сайты.

4.6. Подведение итоговых данных

Проиндексировать произвольный документ, находящийся в Сети, очень сложно. Первые роботы просто сохраняли название документа и якори (anchor) в самом тексте, но новейшие роботы уже используют более продвинутые механизмы и вообще рассматривают полное содержание документа.

Эти методы являются хорошими общими мерами и могут автоматически применяться для всех страниц, но, к сожалению, не могут быть столь же эффективны, как индексация страницы самим ее автором. Язык HTML обеспечивает автора документа средством для того, чтобы присоединить к нему общую информацию. Это средство заключается в определении элемента, например " . Однако, здесь не определяется никакая семантика для специфических значений атрибутов данного HTML-тэга, что серьезно ограничивает его применение, а поэтому и его полноценность. Это ведет к низкой "точности" относительно общего количества запрошенных документов, которые являются релевантными для конкретного запроса. Включение особенностей типа применения булевских операторов, нахождение весов слов, как это делается в WAIS или обратной связи для релевантности, могут улучшить точность документов, но учитывая, что информация, находящаяся в данный момент в Интернет, чрезвычайно разнообразна, эта проблема продолжает быть серьезной и наиболее эффективные пути ее решения пока не найдены.

5. Заключение

Данная работа, естественно, не претендует ни на полноту, ни на точность изложения. Большая часть материала была взята из иностранных источников, в частности, основой послужили обзоры Мартина Костера (Martijn Koster). Поэтому я не исключаю возможности, что данный документ содержит какие-либо неточности, связанные как с переводом, так и с феноменально быстрым развитием информационных технологий. Однако, я все же надеюсь, что данная статья окажется полезной всем, кого интересует Всемирная Сеть Интернет, ее развитие и будущее. В любом случае я буду рад получить отклики о моей работе по E-Mail: [email protected]

6. Список использованной литературы

Павел Храмцов "Поиск и навигация в Internet". http://www.osp.ru/cw/1996/20/31.htm

How Intranet Search Tools and Spiders Work http://linux.manas.kg/books/how_intranets_work/ch32.htm

Martijn Koster "Robots in the Web: threat or treat?" http://info.webcrawler.com/mak/projects/robots/threat-or-treat.html

Обучение Интернет-профессиям. Search engine Expert. http://searchengine.narod.ru/archiv/se_2_250500.htm

Андрей Аликберов "Несколько слов о том, как работают роботы поисковых машин". http://www.citforum.ru/internet/search/art_1.shtml

В настоящее время Интернет объединяет сотни миллионов серверов, на которых размещены миллиарды различных сайтов и отдельных файлов, содержащих различного рода информацию. Это гигантское хранилище информации.

Поиск информации является одной из наиболее распространенных и одновременно сложных задач, с которыми приходится сталкиваться в Сети любому пользователю. Однако если для рядового пользователя знание методов эффективного информационного поиска является желательным, но не обязательным качеством, то для профессионалов в области производственно-конструкторской, организационно-управленческой, научно-исследовательской и дизайнерской деятельности умение быстро ориентироваться в ресурсах Интернет и находить требуемые источники относится к числу базовых квалификационных навыков. Существуют различные приемы поиска информации в Интернет.

Поиск по известному адресу .

Это самый быстрый способ поиска, но его можно использовать только в том случае, если пользователю точно известен адрес информационного ресурса, содержащего необходимую ему информацию. Адреса Web-страниц приводятся в специальных справочниках, печатных изданиях и т.д. Зная адрес, достаточно ввести его в адресную строку браузера.

Например :

− Mgudt.ru - Московский университет дизайна и технологии;

− Sssu.ru - Южно-Российский государственный университет экономики и сервиса;

− Assol.org - САПР одежды, ПО для проектирования сумок, проектирования обуви;

− Saprgrazia.com - высокие компьютерные технологии швейной промышленности;

− Comtense.ru - программное обеспечение и оборудование для автоматизации конструирования и технологической подготовки швейного и трикотажного производства;

− Moda.ru, fg.ru, sarafan.ru - модные тренды;

− Microcoft.com и Microcoft.com/rus - сайт корпорации Microcoft и его русская версия;

− Rarlab.com - архиватор WinRAR;

− 7-zip.org - бесплатный архиватор 7-ZIP;

− Office.microsoft.com/rus - официальный сайт Microsoft Office;

− Abbyy.ru/finereader - Fine Reader (программа распознавания образов);

− Adobe.com/ru/products/photoshop - графический редактор Adobe Photoshop;

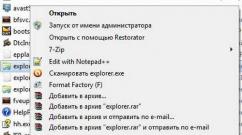

− Avast.ru - бесплатный антивирус Avast! (русская версия);

− Free-av.com - бесплатный антивирус Avira Antivir;

− Drweb.ru - антивирус DrWeb;

− Avp.ru - антивирус Касперского;

− Agnitum.ru - брандмауэр Agnitum Outpost Firewail и пакет безопасности Outpost Security Suite;

− Microcoft.com/rus/windows/internet-explorer - браузер Internet Explorer;

− Opera.com - браузер Opera;

− Ritlabs.com - почтовая программа The Bat;

− Icq.com - служба «мгновенных сообщений» (веб-пейджер) ICQ;

− Icq.rambler.com - русская версия ICQ;

− Skype.com - программа IP-телефонии Skype;

− Yandex.ru, rambler.ru, google.ru - российские поисковые системы;

− Google.com, bing.com - международные поисковые системы;

− Filesearch.ru - поиск на FTP-серверах;

− Mail.ru, mail.yandex.ru, mail.rambler.ru, pochta.ru, e-mail.ru - российские серверы бесплатной почты;

− Narod.ru, boom.ru, westhost.ru, by.ru - бесплатный хостинг на российских серверах;

− Ixbt.ru - компьютерные новости, обзоры hardware;

− Maps.google.com - подробные карты всего мира, с точностью до дома;

− Maps.yandex.ru - подробные карты крупнейших городов России и Украины. Сведения об автомобильных пробках;

− Wikipedia.org и ru.wikipedia.org - свободная энциклопедия Wikipedia и её русский раздел;

− Slovari.yandex.ru, rubricon.com, krugosvet.ru, mega.km.ru - онлайновые энциклопедии и словари;

− Books.ru, ozon.ru, market.yandex.ru, foto.ru - интернет-магазины;

− Rvb.ru - русская виртуальная библиотека;

Навигация по гиперссылкам . Сайты в Интернете связаны между собой с помощью гиперссылок. Если нет адреса нужной Web-страницы, можно использовать другую страницу со ссылкой на нее. При использовании других методов поиска имеет смысл посмотреть, нет ли на найденном сайте раздела ссылок (ресурсы, другие сайты и т.д.). Часто в таком разделе можно найти адреса ещё нескольких ресурсов, тематически связанных с данным. Но этот метод поиска является довольно трудоёмким и с помощью этого метода можно искать документы, только близкие по смыслу текущему документу.

Если у нас нет ни адреса, ни ссылок, обращаются к поисковым системам.

Обращение к поисковому серверу (поисковой системе). Для поиска информации в Интернете разработаны специальные информационно-поисковые системы. Поисковые системы имеют обычный адрес и отображаются в виде Web-страницы, содержащей специальные средства для организации поиска (строку для поиска, тематический каталог, ссылки). Для вызова поисковой системы достаточно ввести ее адрес в адресную строку браузера.

По способу организации поиска информации можно выделить три вида информационно-поисковых систем: тематические каталоги (рубрикаторы), словарные поисковые системы, метапоисковые системы.

Тематические каталоги (рубрикаторы) - поисковые системы, в которых используется иерархическая (древовидная) организация информации, структурированная по темам. При поиске информации пользователь просматривает тематические рубрики и выбирает нужную ветвь, постепенно сужая поле поиска.

Наиболее полный многоуровневый иерархический тематический каталог русскоязычных Интернет-ресурсов имеет поисковая система Апорт (www.aport.ru). Тематические каталоги поисковой системы Апорт представлены на рисунке 18.1. Каталог содержит подробную аннотацию содержания Web-сайтов и указание на их географическое положение.

Рис. 18.1. Тематические каталоги поисковой системы Апорт

Если вы ищете информацию по широкой теме (образование, музыка, медицина и т.д.), чтобы составить общее представление об имеющихся ресурсах на заданную тему то целесообразно обратиться к каталогу. Если же вам необходимо найти конкретный сайт или документ, то каталог окажется малоэффективным поисковым средством.

Например, чтобы найти информацию о ЮРГУЭС в тематическом каталоге Апорт, то нужно пройти достаточно длинный путь по рубрикам Наука и образование / Образование / Высшее профессиональное образование / ВУЗы / Экономика и управление / Остальные. После чего ещё необходимо найти нужную ссылку в алфавитном списке из 15 страниц. Но зато этот путь позволил составить общее представление о многообразии российских образовательных ресурсов.

Кроме каталогов общего назначения в Сети много специализированных каталогов (по определённым темам).

Словарные поисковые системы - это мощные автоматические программно-аппаратные комплексы. Основой поисковых систем являются так называемые поисковые машины, или индексы. Специальные программы-роботы (известные также как «пауки») в автоматическом режиме периодически обследуют Интернет на основе определенных алгоритмов, проводя индексацию найденных документов. В специальные справочники-индексы заносятся данные о местонахождении той или иной информации. Созданные индексные базы данных используются поисковыми машинами для предоставления пользователю доступа к размещенной на узлах Сети информации. Пользователь в рамках соответствующего интерфейса формулирует запрос , который обрабатывается системой.

Запрос - это ключевое слово или фраза, сформированная по определенным правилам - с помощью языка запросов, которую вводит пользователь в строку поиска. Для формирования различных запросов используются специальные символы ("", ~), математические символы (*, +, -, ?), логические операторы (операции) Or, And, Not, оператор близости Near.

После этого в окно браузера выдаются результаты обработки запроса. В результате пользователю предлагаются те адреса (URL), по которым в момент сканирования найдены искомое слово или группа слов. Список ссылок, предлагаемый пользователю, ранжируется по релевантности . Релевантный документ - это документ, смысловое содержание которого соответствует информационному запросу.

Каждая ссылка в списке результатов поиска содержит сниппет (англ. snippet - фрагмент, отрывок) - несколько строчек из найденного документа, среди которых встречаются искомые ключевые слова. Прежде чем переходить по ссылке, целесообразно оценить соответствие сниппета теме запроса. Затем, перейдя по ссылке на определенный сайт, стоит просмотреть главную страницу. Как правило, первой страницы достаточно, чтобы понять - по адресу вы пришли или нет. Если да, то дальнейшие поиски нужной информации ведите на выбранном сайте (в разделах сайта), если нет - возвращайтесь к результатам поиска и пробуйте очередную ссылку.

Этот вид поиска является самым гибким и мощным и позволяет искать в Сети информацию, посвящённую самой разнообразной, в том числе узкоспециальной, тематике.

В настоящее время в развитии поисковых систем наблюдается тенденция объединения автоматических индексных поисковых машин и составляемых вручную каталогов Интернет-ресурсов. Ресурсы этих систем удачно дополняют друг друга, и объединение их возможностей вполне логично. Большинство современных поисковых систем являются смешанными.

Поисковых систем сегодня существует достаточно много, международных и отечественных. Первые индексируют все опубликованные в Интернете документы подряд. Вторые индексируют ресурсы, расположенные в доменных зонах с преобладанием русского языка. Если перед пользователем стоит задача найти что-либо в русскоязычной части сети, то, скорее всего, наиболее успешный результат даст поиск с использованием русскоязычных поисковиков. Прежде всего, потому, что русскоязычные поисковые сервера, в отличие от англоязычных, ведут поиск с учетом морфологии русского языка. Наиболее популярные поисковые системы приведены в таблице 26.

Федеральное агентство по образованию

Смоленский государственный университет

Технологии поиска информации в сети Интернет.

Смоленск

Введение………………………………………………………………………….. 1.Классификация поисковых систем …………………………………………... 2.Приемы поиска……………………………………………………………….... 2.1.Простой поиск……………………………………………………………….. 2.2.Расширенный поиск…………………………………………………………. 3.Тематический каталог Yahoo.………………………………………………… 4.Автоматический индекс Alta Vista…………………………………………… 5.Поиск информации в конференциях (Usenet)……………………………….. 6.Отечественные поисковые службы ………………………………………….. 6.1.Rambler………………………………………………………………………. 6.2.Яндекс…………………………………………………………………………. 7.Поиск файлов ………………………………………………………………….. 8.Источники специализированной информации ……………………………… 9.Поиск отдельных людей в сети Internet ……………………………………... 10.Метапоиск…………………………………………………………………….. 11.Эффективный поиск информации…………………………………………... Заключение……………………………………………………………………….Литература……………………………………………………………………….. |

3 3 6 6 8 10 12 13 14 15 15 16 17 18 19 19 21 22 |

Введение

Любой, кто пытался когда-нибудь найти нужную информацию в Интернете, наверняка согласится с тем, что этот процесс похож на поиск иголки в стоге сена. Глобальная сеть Internet содержит огромный объем информации, который стремительно увеличивается с каждым днем. В силу этого часто оказывается, что задача нахождения необходимой информации в этом информационном океане является чрезвычайно сложной и нужно уметь эффективно использовать различные поисковые системы (программы поиска информации в сети). Необходимо учесть, что "поиск - это искусство".

1. Классификация поисковых систем

Существует много разных поисковых систем принадлежащих разным компаниям. Прежде всего, выделяют так называемые тематические каталоги (например, Yahoo) и автоматические индексы (например, AltaVista), хотя необходимо иметь ввиду, что целый ряд поисковых систем занимает некоторое промежуточное положение между этими двумя "полюсами", то есть они содержат в себе элементы обоих этих классов. Каждая из поисковых систем имеет свою обширную базу данных об адресах (местоположении) различных Web-документов, и поиск ссылок на необходимую нам информацию происходит, не в самих Web-документах, а именно в этой базе данных.

Существует много разных поисковых систем принадлежащих разным компаниям. Прежде всего, выделяют так называемые тематические каталоги (например, Yahoo) и автоматические индексы (например, AltaVista), хотя необходимо иметь ввиду, что целый ряд поисковых систем занимает некоторое промежуточное положение между этими двумя "полюсами", то есть они содержат в себе элементы обоих этих классов. Каждая из поисковых систем имеет свою обширную базу данных об адресах (местоположении) различных Web-документов, и поиск ссылок на необходимую нам информацию происходит, не в самих Web-документах, а именно в этой базе данных.

Тематические каталоги и автоматические индексы различаются, прежде всего, по тому, как формируются и пополняются их базы данных: принимают ли в этом процессе участие люди, или все происходит совершенно автоматически.

Базы данных тематических каталогов составляются и систематически пополняются экспертами в соответствующих областях на основании новых Web-документов, обнаруженных в Internet специальными поисковыми программами. Тематический каталог представляет пользователю Internet некоторую древовидную структуру категорий (разделов и подразделов), на верхнем уровне которой собраны самые общие понятия, такие как Наука, Искусство, Бизнес и т. п., а элементы самого нижнего уровня представляют собой ссылки на отдельные Web-страницы и серверы вместе с кратким описанием их содержимого. По этому иерархическому каталогу можно путешествовать, начиная с более общих категорий (понятий) к более узким, специализированным.

Например, для нахождения информации о состоянии научных исследований по теории суперструн можно спуститься вниз по следующей "лестнице" понятий:

Science (Наука)

Physics (Физика)

Theoretical Physics (Теоретическая физика)

Theories (Теории)

String Theories (Теорииструн)

В результате будет получен список сайтов, среди которых наибольший интерес представляет сайт Superstrings. Щелкнув мышью на гиперссылке Superstrings, мы попадаем на home page сайта, с соответствующим заголовком, на котором можно найти on-line учебник по теории суперструн, различные ссылки для дальнейшего чтения, глоссарий по суперструнам и т.д.

Главным достоинством тематических каталогов является большая ценность получаемой пользователем информации, что обеспечивается присутствием "человеческого фактора" в процессе анализа и сортировки новых Web-страниц. С другой стороны, тематические каталоги имеют существенный недостаток, связанный опять же с человеческим фактором, ибо из-за ограниченных возможностей человека их базы данных охватывают лишь небольшую часть всего информационного Web-пространства (менее 1 %). Таким образом, несмотря на всю полезность тематических каталогов, использование лишь поисковых систем этого вида часто оказывается явно недостаточным.

Сводная таблица избранных предметных каталогов

| List.Ru | Апорт | Яндекс | Rambler | Yahoo! | About | |

| Общая характеристика | 19 разделов верхнего уровня | 14 разделов верхнего уровня | 10 основных разделов, 7 комбинированных, дополнительная классификация | 56 разделов | 14 основных разделов | 36 разделов |

| Сортировка ресурсов внутри раздела | Алфавит, оценка гидов, популярность (посещаемость), дата | Алфавит, посещаемость, лига, оценка числа ссылок на данный ресурс, мнение пользователей | Алфавит, дата добавления, индекс цитируемости | по посещаемости | по алфавиту | по оплаченности ссылок |

| Булевские операторы | Используется язык поисковой машины Апорт | Используется язык поисковой машины Яndex | Используется язык поисковой машины Rambler | Нет | Нет | |

| Поиск по фразе | " " | " " | ||||

| Префиксы | +, - | +, - | ||||

| Итеративный поиск (в результатах) | Есть поиск внутри категории | После входа щелкните More… | ||||

| замена части слова | * | * (не всегда корректно) |

В отличие от тематических каталогов, базы данных для автоматических индексов создаются и пополняются полностью автоматически некоторыми специальными, внутренними поисковыми программами-роботами, которые в круглосуточном режиме просматривают Internet-узлы (сайты) в поисках вновь появившихся Web-документов. Из каждого такого документа робот извлекает все содержащиеся в нем новые ссылки и добавляет их в свою базу адресов, в результате чего у программы-робота возникает возможность просмотра еще некоторого количества новых для него Web-документов. В каждом новом Web-документе робот анализирует все входящие в него слова и в разделе базы данных, соответствующем каждому данному слову, запоминается адрес (URL) документа, где это слово встретилось. Таким образом, база данных, создаваемая автоматическим индексом, фактически хранит сведения о том, в каких Web-документах содержаться те или иные слова. В отличие от тематических каталогов, автоматические индексы охватывают до 25 % общего Web-пространства.

Автоматический индекс имеет отдельную поисковую систему для обеспечения интерфейса с пользователем. Эта система может, просматривая базу данных, по заданному набору ключевых слов находить и выдавать на экран пользовательского компьютера адреса и краткую информацию обо всех Web-страницах, которые содержат данный набор ключевых слов. Таким образом, автоматический индекс состоит из трех частей: программы-робота, собираемой этим роботом базы данных и интерфейса для поиска в этой базе данных. Именно с последней составляющей и работает пользователь. В силу такой организации, автоматический индекс не делает какой-либо классификации или оценивания информации.

Интерфейс автоматических индексов позволяет пользователю задать некоторый набор ключевых слов, которые с его точки зрения, являются характерными для искомых им документов, и позволяют, таким образом, найти достаточно ограниченное число потенциально относящихся к делу Web-страниц. В качестве таковых слов могут быть использованы некоторые специфические термины и их комбинации, достаточно редкие фамилии и т. д.

Успех поиска нужной информации в значительной степени определяется именно удачным выбором ключевых слов, ибо в противном случае поисковая система может выдать многие тысячи и миллионы ссылок на не относящиеся к делу Web-документы.

Следует иметь ввиду, что начинающего пользователя подстерегает много разных неожиданностей, иногда доходящих до анекдотических ситуаций.

Если для автоматических индексов поиск по ключевым словам является единственным средством нахождения необходимой информации, то в тематических каталогах (например, в Yahoo!) это средство является альтернативным способом поиска наряду с путешествием по системе (дереву) вложенных друг в друга категорий.

Некоторой разновидностью поисковых служб являются рейтинговые службы. Они предоставляют клиенту готовый список некоторых ссылок, к которым обращались наиболее часто другие пользователи сети Internet. Когда речь идет о темах, имеющих общественный интерес, таких как новости, музыка и т. д., такие рекомендации, полученные статистическим методом, являются весьма удобными и полезными. Такие услуги, в частности, обеспечивает отечественная служба Rambler.

2. Приемы поиска

2.1. Простой поиск

Каждая поисковая система (ПС) предоставляет свои методы поиска и имеет свои особенности в правилах записи комбинаций ключевых слов. Однако есть общие элементы одинаково справедливые для большинства поисковых систем. Обычно все ПС допускают поиск Web-документов по ключевым словам, которые являются характерными для искомого документа. Выбор таких слов часто является нетривиальной задачей.

Казалось бы, нет ничего проще, чем найти нужные данные в Сети. В реальности с этим может справиться даже тот, кто впервые воспользовался услугами поисковых систем. Однако в то же время с эффективностью такого поиска можно будет серьезно поспорить. Намного меньше времени можно потратить на поиск информации в Сети, располагая необходимыми сведениями об особенностях работы популярных поисковых систем.

В глобальной Сети применяют во время обработки запросов собственную машинную логику. Опираясь на несколько несложных правил и располагая достаточной информацией об использовании популярных поисковиков, можно значительно ускорить процесс нахождения необходимой информации, а самое главное - в результате вы получите именно то, что требуется.

Особенности составления поискового запроса

Как правильно искать в Интернете необходимую информацию? Для этого, в первую очередь, необходимо знать эффективные приемы удачного составления поисковых запросов. Выполнение поиска по единственному слову обычно приводит к выдаче результатов в виде миллионов страниц, большинство из которых абсолютно не относится к делу. Если в поисковой строке находится от четырех до шести значений и более, количество результатов автоматически сокращается до нескольких тысяч и сотен, а иногда ограничивается лишь парой страниц.

Более того, поиск в Интернете нуждается в составлении грамотных запросов. Чем точнее указано искомое слово или словосочетание, тем выше вероятность обнаружить необходимые данные на первой же странице в выдаче результатов. Все дело в том, что поисковикам далеко не всегда удается исправить ошибки орфографии, допущенные пользователем, а некоторые из них попросту упускаются. А ведь в отдельных случаях точность запроса может оказаться достаточно принципиальной.

Помимо прочего, не следует игнорировать необходимость введения заглавных букв, если запрос касается поиска человека по фамилии либо имен собственных. В противном случае среди подходящих страниц в результате поиска обязательно будет присутствовать достаточная масса неподходящих, косвенно касающихся запроса данных.

Почему важно использовать несколько поисковых систем?

Выполняя поиск в Интернете, крайне важно применять, как минимум, два поисковика. Ведь на получение результатов при этом будут влиять разные способы То, что не замечает один поисковик, обязательно заметит другая система. Например, использование отечественной поисковой системы может переместить необходимую информацию на несколько страниц вперед, и в то же время иностранная выдаст тот же результат в первой пятерке.

Выполнение поиска согласно синонимам

Что больше ищут в Интернете? Обычно предметом поиска пользователей оказывается медиа контент и развлечения, в частности, фильмы, музыка, компьютерные игры. При этом люди далеко не всегда нуждаются в нахождении конкретного запроса. Часто в результатах выдачи необходимо увидеть общую информацию, различные варианты одного значения.

Для поиска схожей информации согласно выбранному запросу применяется символ «~», который необходимо расположить перед запросом в поисковой строке. Например, задав запрос «~лучшие игры», в конечном итоге можно увидеть ссылки на страницы, где не будет присутствовать ни одного совпадения с определением «лучшие». Однако здесь окажется достаточно синонимов к данному определению.

Как получить несколько результатов одновременно?

Как искать информацию в Интернете, чтобы получить одновременно несколько результатов выдачи? Для этого используется разделение пары запросов специальным оператором «|», который может располагаться, как между несколькими словами, так и фразами. Например, разделив таким образом запросы «купить автомобиль» и «купить мотоцикл», можно быстро получить страницы, содержащие оба варианта.

Использование преимуществ расширенного поиска

Применение функции расширенного поиска дает возможность избежать самостоятельного формирования уточняющих запросов. Вместо этого можно воспользоваться теми вариантами, которые предлагает непосредственно поисковая система.

Большинство поисковиков знают, что искать в Интернете намного лучше по сравнению с самыми продвинутыми пользователями, так как основывают свою работу на статистике формирования популярных запросов. Поэтому задавая поисковику запрос в виде искомого слова, лучше сразу же конкретизировать его при помощи функционала расширенного поиска.

Как быстро отыскать значение незнакомого понятия?

Что люди ищут в Интернете? Нередко предметом поиска становятся незнакомые пользователю материалы, а также понятия, в сути которых нужно разобраться. Чтобы моментально отыскать значение тех или иных определений, достаточно всего лишь разместить перед запросом «define:».

Просмотр результатов из первого десятка страниц

Что искать в Интернете? В первую очередь, обращать внимание следует на первые результаты выдачи поисковой системы. Ведь именно здесь обычно встречаются не только самые соответствующие запросу данные, но также результаты, найденные на наиболее популярных среди пользователей страницах. Как правило, это самые уважаемые, проверенные Интернет порталы с содержанием точной, отвечающей запросам пользователя информации.

Уточнение географии искомых данных

Наименее актуальной необходимость уточнения географии запроса выглядит для жителей столиц и крупных городов, однако она остается важной для пользователей из отдаленных регионов. Несмотря на автоматическое определение местоположения пользователя, которое выполняется большинством продвинутых поисковых систем, в результатах на первых позициях обязательно окажутся ссылки, связанные с крупными населенными пунктами. Ведь именно в таких местах сконцентрирована основная масса активных пользователей.

Исходя из вышесказанного, не стоит слишком надеяться на то, что поисковик определит, из какой точки на карте исходит запрос. Вместо этого лучше сразу же добавить к искомому запросу упоминание о месте своего пребывания.

Не стоит забывать и жителям столичных областей, что искать в Интернете информацию подобным образом наиболее целесообразно. Ведь нужные товары или услуги запросто могут оказаться за пределами города. Иногда самое простое упоминание конкретного региона, улицы или даже станции метро способствует быстрому нахождению необходимых магазинов, компаний или сервисов, которые располагаются ближе всего по отношению к месту пребывания пользователя.

Общие сведения.

В настоящее время Интернет объединяет сотни миллионов серверов, на которых размещены миллиарды различных сайтов и отдельных файлов, содержащих различного рода информацию. Это гигантское хранилище информации. Существуют различные приемы поиска информации в Интернет.

Поиск по известному адресу. Необходимые адреса берутся из справочников. Зная адрес, достаточно ввести его в адресную строку Браузера.

www.gov.ru - сервер органов государственной власти России.

Конструирование адреса пользователем. Зная систему формирования адреса в Интернет, можно при поискеWeb-сайтов конструировать адреса.

К ключевому слову (названию фирмы, предприятия, организации или простому английскому существительному) необходимо добавить домен тематический или географический, при этом необходимо подключать интуицию.

Адреса коммерческих Web-страниц:

www.cnn.com (всемирные новости CNN),

www.sony.com (фирма SONY),

www.mtv.com (музыкальные новости MTV).

Адреса учебных заведений:

www.ntu.edu (Национальный университет США).

Адреса региональных серверов:

www.poland.net (Польша),

www.israil.net (Израиль).

Поисковые системы Интернет

Для поиска информации в Интернет разработаны специальные информационно-поисковые системы. Поисковые системы имеют обычный адрес и отображаются в виде Web-страницы, содержащей специальные средства для организации поиска (строку для поиска, тематический каталог, ссылки). Для вызова поисковой системы достаточно ввести ее адрес в адресную строку Браузера.

По способу организации информации информационно-поисковые системы делятся на два вида: классификационные (рубрикаторы) и словарные.

Рубрикаторы (классификаторы) - поисковые системы, в которых используется иерархическая (древовидная) организация информации. При поиске информации пользователь просматривает тематические рубрики, постепенно сужая поле поиска (например, если необходимо найти значение какого-то слова, то сначала в классификаторе нужно найти словарь, а затем уже в нем найти нужное слово).

Словарные поисковые системы - это мощные автоматические программно-аппаратные комплексы. С их помощью просматривается (сканируется) информация в Интернет. В специальные справочники-индексы заносятся данные о местонахождении той или иной информации. В ответ на запрос осуществляется поиск в соответствии со строкой запроса. В результате пользователю предлагаются те адреса (URL), на которых в момент сканирования найдены искомые слово или группа слов. Выбрав любой из предложенных адресов-ссылок, можно перейти к найденному документу. Большинство современных поисковых систем являются смешанными.

Наиболее известные и популярные системы поиска:

www.aport.ru www.yahoo.com www.rambler.ru www.yandex.ru www.altavista.com www.google.com

Существуют системы, специализирующиеся на поиске информационных ресурсов по различным направлениям.

Поиск людей в Интернет:

www.whowhere.ru ww. bigfoot.com

Поиск по телеконференциям (Usenet):

www.dejanews.com

Предметные поисковые системы:

Поиск программного обеспечения:

Поиск по файловым архивам:

http://ftpseach. city.ru, http://ftpsearch. licos.com

Каталоги (тематические подборки ссылок с аннотациями):

http://www.atrus.ru

Часто эффективный поиск информации можно провести с помощью региональных каталогов - специализированных серверов, содержащих данные о предприятиях или Web-ресурсах какого-то города или региона. Например, для Санкт-Петербурга такой каталог располагается по адресу http://www.spb.ru.

Список ИПС можно найти на сайте www.monk. newmail.ru

Более подробный перечень поисковых систем и каталогов представлен в табл. 3.2.

Правила выполнения запросов

В каждой поисковой системе в разделе Помощь (Help) можно получить сведения о том, как искать, как составить строку запроса. Ниже приведена информация о типовом, "усредненном" языке запросов.

Простой запрос.

Ввести одно слово, определяющее тему поиска. Например, в поисковой системе Rambler.ru достаточно ввести: автоматика.

Находятся документы, в которых встречаются слова, указанные в запросе. Распознаются все формы слов русского языка, как правило, регистр букв игнорируется.

В запросе можно использовать символ "*" или "?". Знаком "?" в ключевом слове заменяется один символ, на место которого может быть подставлена любая буква, а знаком "*" - последовательность символов.

Например, запрос автомат* позволит найти документы, включающие слова автоматический, автоматика и т.д.

Сложный запрос.

Часто возникает необходимость комбинирования ключевых слов для получения более определенной информации. В этом случае используются дополнительные слова-связки, функции, операторы, символы, комбинации операторов, разделенные скобками.

Например, запрос музыка & (beatles | битлз) означает, что пользователь ищет документы, содержащие слова музыка и beatles или музыка и битлз.

В табл.3.1 приведены правила формирования запросов, принятые в системе Апорт (http://www.aport.ru).

Таблица 3.1

Операторы для формирования запросов

| Оператор | Синонимы | Комментарий |

| И | AND & | По запросу будут найдены документы, содержащие оба ключевых слова. Его можно и не писать. Например, запрос: информатика и учебник эквивалентен информатика учебник |

| ИЛИ | OR | | Производится поиск тех документов, в которых используется любое из указанных слов или оба слова одновременно |

| НЕ | NOT - ~ | Поиск ограничивается документами, не содержащими слово, указанное после оператора |

| " " | " " | Двойные или одинарные кавычки позволяют находить словосочетание |

| Дата= | дата: date= | Поиск ограничивается документами, попадающими в заданный интервал дат. Пример 1. валюта дата=01/02/2002-01/03/2002. По этому запросу будут выданы документы, содержащие слово "валюта" и имеющие дату от 1 февраля 2002 г. до 1 марта 2002 г. Пример 2. date=01/03/2002 валюта Пример 3. дата: <02/03/2002 валюта |

Таблица 3.2

Список поисковых серверов и каталогов

| Адрес | Описание |

| www.excite.com | Поисковый сервер с обзорами узлов и путеводителями |

| www.alta-vista.com | Поисковый сервер, имеются возможности расширенного поиска |

| www.hotbot.com | Поисковый сервер |

| www.poland.net www.israil.net | Региональные поисковые серверы Польши, Израиля |

| www.ifoseek.com | Поисковый сервер (простой в использовании) |

| www.ipl.org | Internet Publik library, публичная библиотека, функционирующая в рамках проекта "Всемирная деревня" |

| www.wisewire.com | WiseWire - организация поиска с применением искусственного интеллекта |

| www.webcrawler.com | WebCrawler - поисковый сервер, прост в обращении |

| www.yahoo.com | КаталогWeb и интерфейс для обращения к полнотекстовому поиску на сервере AltaVista |

| www.aport.ru | Апорт - русскоязычный поисковый сервер |

| www.yandex.ru | Яндекс - русскоязычный поисковый сервер |

| www.rambler.ru | Рамблер - русскоязычный поисковый сервер |

| Справочные ресурсы Интернет | |

| www.yellow.com | Желтые страницы Интернет |

| monk. newmail.ru | Поисковые системы различного профиля |

| www.top200.ru | 200 лучшихWeb-сайтов |

| www.allru.net | |

| www.ru | Каталог русских ресурсов Интернет |

| www.allru.net/z09. htm | Образовательные ресурсы |

| www.students.ru | Сервер российского студенчества |

| www.cdo.ru/index_new. asp | Центр дистанционного обучения |

| www.open. ac. uk | Открытый университет Великобритании |

| www.ntu.edu | Национальный университет США |

| www.translate.ru | Электронный переводчик текстов |

| www.pomorsu.ru/guide. library.html | Список ссылок на сетевые библиотеки |

| www.elibrary.ru | Научная электронная библиотека |

| www.citforum.ru | Электронная библиотека |

| www.infamed.com/psy | Психологические тесты |

| www.pokoleniye.ru | Web-сайт Федерации Интернет образования |

| www.metod. narod.ru | Образовательные ресурсы |

| www.spb. osi.ru/ic/distant | Дистанционное обучение в Интернет |

| www.examen.ru | Экзамены и тесты |

| www.kbsu.ru/~book/ | Учебник информатики |

| Mega. km.ru | Энциклопедии и словари |

Поиск информации в Интернете: подводные камни

Проблемы, не лежащие на поверхности, нередко дают о себе знать лишь "задним числом", после того как определенный этап поисковых работ завершен и, возможно, исходя из его результатов уже принято какое-либо решение. Что же мешает сделать ситуацию прозрачной с самого начала эксплуатации той или иной информационно-поисковой системы (ИПС)? Ответ довольно прост: отсутствие исчерпывающей информации подобного рода со стороны разработчика. Прямым следствием этого становятся недостоверность получаемых данных и их неконтролируемая потеря. Редко удается встретить в Сети поисковую систему, которая не обладала бы некоторыми "недокументированными" особенностями. Казалось бы - пользователю необходимо не так уж много сведений, а именно:

как происходит наполнение базы данных ИПС и каков ее объем;

полный спектр возможностей поискового языка системы;

основные особенности представления результатов поиска, прежде всего алгоритма ранжирования записей из списка отклика на поисковый запрос.

Увы, источником подобной информации обычно является не документ, доступный с головной страницы поискового сервера, а разбросанные по Сети, книгам и компьютерным журналам публикации отдельных авторов. К причинам такого положения дел, по-видимому, можно отнести не только небрежность разработчика, но и фактор, именуемый маркетинговой политикой. Проще говоря, предоставление поисковой системой наиболее полной информации о самой себе не всегда положительно сказывается на ее рейтинге. Тем не менее, взять ситуацию под контроль в ряде случаев пользователю оказывается вполне по силам. Выяснить особенности работы избранного поискового сервиса часто удается с помощью тестирования. Построение специальных тестовых запросов, быстро проясняющих именно тот аспект работы системы, который наиболее важен для текущей задачи, во многих случаях оказывается нетривиальным. Тому, как избежать некоторых неприятностей при работе с ИПС, мы и посвятим наше обсуждение. В качестве примеров, иллюстрирующих изложение, будут рассмотрены широко известные поисковые системы Интернета.